La cultura de IA es la forma en que una empresa piensa, aprende y trabaja con Inteligencia Artificial en el día a día. No se trata solo de “tener herramientas” o de que un área use IA de vez en cuando, sino de que toda la organización adopte hábitos como probar ideas en pequeño, medir resultados y mejorar, y hacerlo de manera responsable con reglas, controles y respeto por las personas.

Realidad: la IA no es magia y eso es bueno: En la práctica, la IA ayuda cuando hay objetivos claros, datos adecuados y personas preparadas. También puede fallar, dar respuestas incorrectas o amplificar sesgos; por eso se recomienda gestionar riesgos, probar y monitorear continuamente.

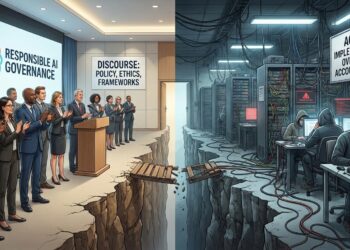

Retos principales, lo que más frena una cultura de IA:

- Falta de claridad en el “para qué”: Muchas iniciativas fallan por empezar con la tecnología y no con un problema real del negocio.

- Control de datos y privacidad: Sin control sobre la calidad de los datos y sin reglas claras para protegerlos, la IA puede generar resultados poco confiables y aumentar riesgos de seguridad y privacidad.

- Habilidades y capacitación: No basta con tener un equipo técnico. La empresa debe desarrollar habilidades en todos los niveles (liderazgo y equipos operativos): entender qué puede y qué no puede hacer la IA, cómo usarla de forma correcta y cómo revisar/validar sus resultados antes de tomar decisiones.

- Riesgo, seguridad y errores: La IA debe probarse, controlarse y revisarse; el riesgo no desaparece, se administra.

- Responsabilidad: ¿quién responde?: Debe ser claro quién aprueba modelos, quién válida resultados y quién toma la decisión final.

Realidades que sí funcionan, cómo se fomenta la cultura de IA:

- Control y gobierno desde el inicio, primero lo primero: Roles y flujos para definir quién aprueba y quién revisa, qué datos pueden usarse (catalogados, clasificados y, cuando aplique, certificados) y qué riesgos no se aceptan. Implementar políticas de acceso y privacidad, seguridad, trazabilidad/auditoría y workflows de validación humana cuando corresponda.

- Habilidades prácticas (incluye “prompting” ): Enseñar a los equipos a usar IA con criterio: escribir prompts útiles, dar contexto correcto, pedir formatos, y sobre todo verificar resultados (fuentes, cálculos, datos sensibles).

- Reglas internas simples (políticas de uso): Qué herramientas están aprobadas, qué información nunca se comparte, cuándo es obligatoria la revisión humana, y cómo se reportan errores o incidentes.

- Transparencia y confianza: La transparencia y confianza se construyen cuando la empresa explica de forma simple cuándo se usa IA, para qué, qué parte del proceso decide la IA y qué parte decide una persona, además de reconocer sus límites (puede equivocarse) y cómo se cuida la responsabilidad y el trato justo; para que eso sea real, conviene habilitar canales de comunicación claros.

Construir una cultura de IA significa aceptar retos reales (datos, habilidades, riesgo y responsabilidad) y convertirlos en hábitos: aprender, medir, corregir y comunicar. En nuestra experiencia, esto no ocurre de un día para otro: es un proceso difícil, a veces duro, y siempre toma tiempo, porque requiere cambiar la forma de trabajar, capacitar equipos, ajustar controles y aprender de errores reales. Por eso, la meta no es usar “más IA”, sino usarla mejor, de forma responsable y con confianza, avanzando paso a paso y mejorando con cada iteración.